L’intelligenza artificiale ha rivoluzionato il modo in cui interagiamo con la tecnologia, ma fino a oggi è rimasta confinata negli schermi. Google cambia le regole annunciando Gemini Robotics, un modello che combina visione, linguaggio e azione per permettere ai robot di adattarsi agli ambienti e interagire con le persone in modo naturale.

Basato su Gemini 2.0, il sistema permette ai robot di eseguire una gamma di compiti più ampia che mai, interpretando le istruzioni con un linguaggio colloquiale e regolando le proprie azioni in tempo reale. A supporto di questa evoluzione, Google ha sviluppato anche Gemini Robotics-ER, una versione avanzata con una comprensione spaziale superiore, pensata per chi progetta robot con capacità decisionali più sofisticate.

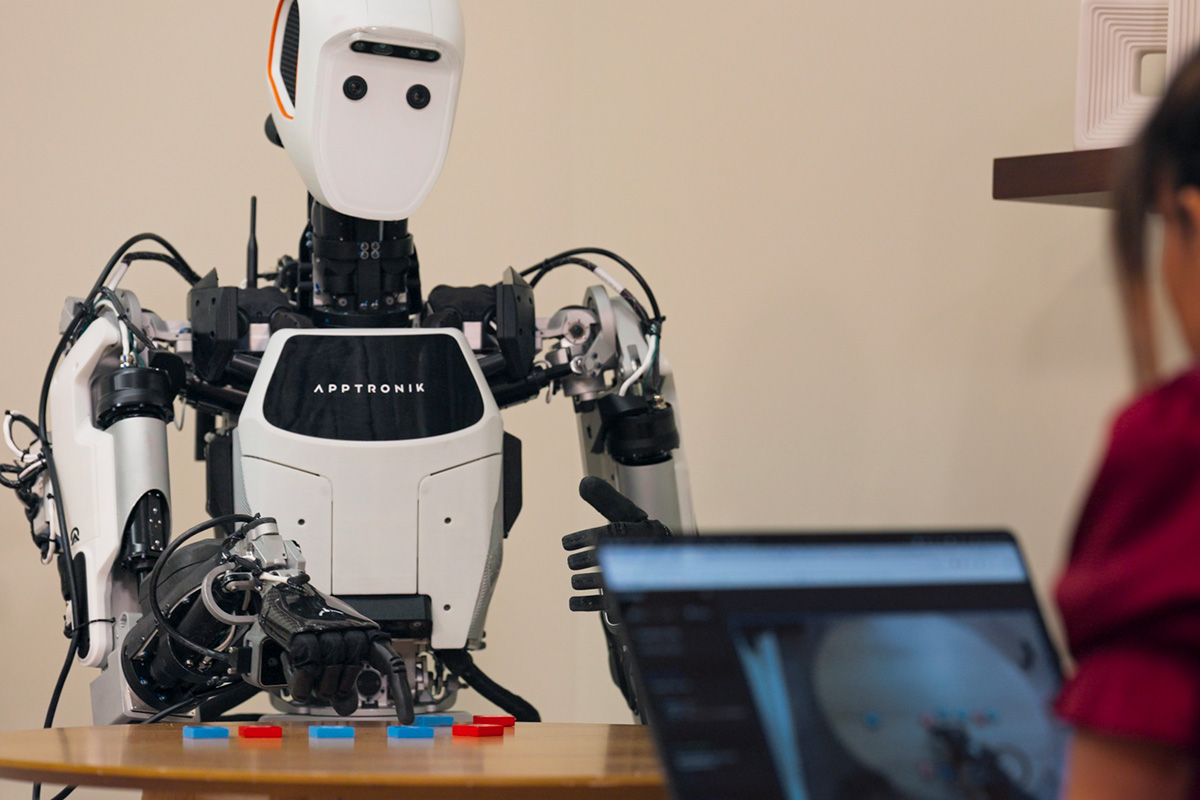

Il progetto sta già prendendo forma grazie a collaborazioni con aziende specializzate nella robotica come Apptronik, Boston Dynamics e Agility Robotics. L’obiettivo è chiaro: portare l’AI oltre il mondo digitale e renderla uno strumento concreto per automatizzare compiti complessi, dall’industria alla logistica, fino agli ambienti domestici.

La vera innovazione di Gemini Robotics sta nella sua capacità di comprendere il linguaggio naturale senza bisogno di programmazione complessa. Se fino a ieri i robot necessitavano di istruzioni dettagliate, ora possono interpretare i comandi in modo più intuitivo e adattarsi all’ambiente circostante. Questa flessibilità apre la strada a un’adozione più ampia della robotica, anche in contesti dove l’automazione tradizionale sarebbe troppo rigida o complessa da implementare.

Un’AI in grado di agire nel mondo reale deve anche garantire il massimo livello di sicurezza. Per questo Google ha sviluppato il dataset Asimov, un sistema pensato per valutare e migliorare la sicurezza delle azioni robotiche, aiutando i modelli a riconoscere potenziali rischi prima ancora di eseguire un’azione. La robotica basata sull’intelligenza artificiale sta entrando in una nuova fase, più interattiva e consapevole.

© Riproduzione riservata